Trong khi sức mạnh xử lý tác vụ AI trên chip Nvidia đang tăng gấp đôi sau mỗi năm, họ cần một cánh cửa để mở rộng khả năng ứng dụng sức mạnh đó của mình, và ARM Holdings là cánh cửa mà Nvidia cần.

Từ nhiều thập kỷ nay, ngành công nghiệp điện toán đã vận hành dưới sự thống trị của Định luật Moore, với tuyên bố số lượng bóng bán dẫn trên mỗi con chip sẽ tăng gấp đôi sau mỗi 2 năm. Điều này cũng có nghĩa hiệu năng của những con chip này – và cả những chiếc máy tính trang bị nó – đều sẽ tăng lên tương ứng với khung thời gian đó.

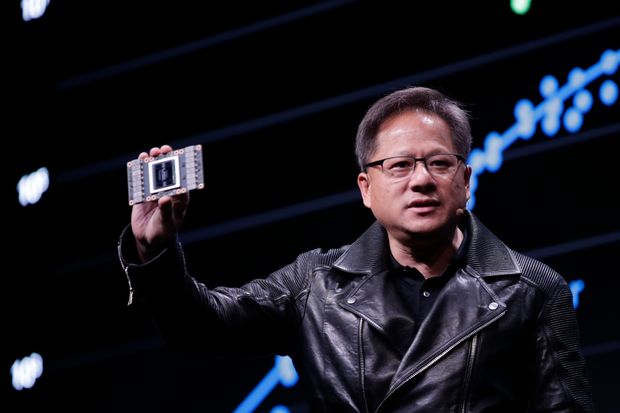

Nhưng khi các nhà sản xuất chip đã gần chạm đến ngưỡng kích thước nguyên tử đối với các mạch bán dẫn và vật lý điện, định luật Moore đã chậm lại và một số còn cho rằng, nó đã kết thúc. Nhưng lúc này đang có một định luật khác nổi lên, và rất có thể không sớm thì muộn, nó sẽ thống trị ngành điện toán trong nửa thế kỷ sắp tới. Và tạp chí Wall Street Journal đang gọi nó là Định luật Huang – đặt theo tên nhà đồng sáng lập và là CEO Nvidia, Jensen Huang.

Định luật này cho rằng, sức mạnh của những con chip dành cho tác vụ trí tuệ nhân tạo (hay chip AI) sẽ tăng gấp đôi sau mỗi 2 năm. Mặc dù sự gia tăng này đến cả từ phần cứng và phần mềm, nhưng đà tăng ổn định của nó đang biến chip AI thành linh kiện thống trị mọi thứ, từ các phương tiện tự hành cho đến khả năng nhận dạng giọng nói, âm thanh, gương mặt trên các thiết bị cá nhân.

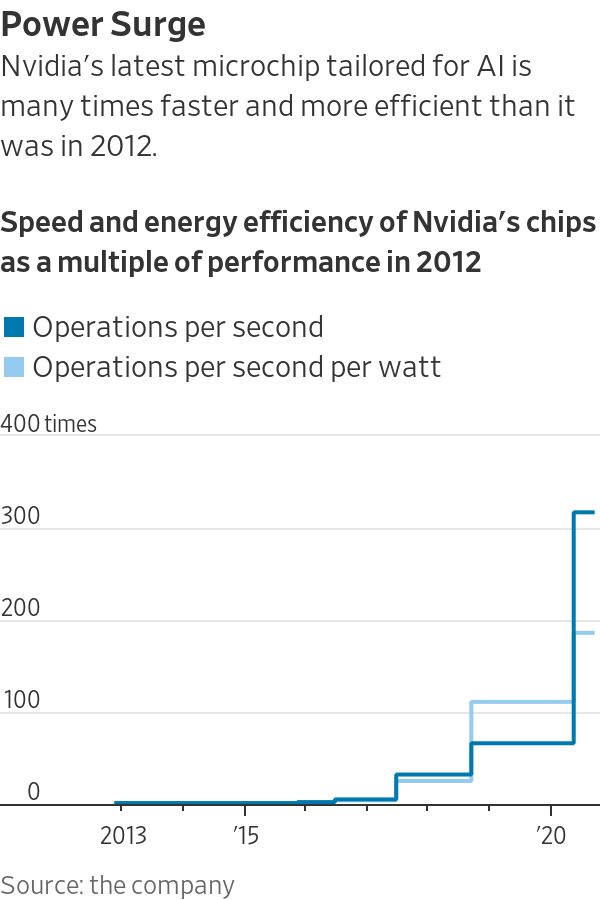

Theo nhà khoa học trưởng và phó chủ tịch nghiên cứu của Nvidia, ông Bill Dally, từ tháng 11 năm 2012 đến tháng 5 năm nay, hiệu năng của chip Nvidia đã tăng 317 lần đối với một lớp khả năng tính toán quan trọng của AI. Nói cách khác, trung bình hiệu năng của những con chip này đã tăng gấp đôi sau mỗi năm, một tốc độ còn vượt xa cả Định luật Moore.

Từ lâu Nvidia tập trung vào xây dựng các bộ xử lý đồ họa, hay GPU, một thành phần điện toán chuyên xử lý song song nhiều tác vụ độc lập. Trong khi đó, các bộ xử lý trung tâm, hay CPU, thành phần thuộc về chuyên môn của Intel, dù thực hiện rất nhanh các tác vụ đơn nhất liên tiếp nhau, lại rất kém cỏi khi thực hiện các tác vụ song song này.

Chính vì vậy, cho dù bạn không thể làm mọi việc bằng GPU, nhưng với các tác vụ cần xử lý song song – bao gồm cả các ứng dụng AI – GPU có thể thực hiện nhanh gấp nhiều lần CPU với cùng sức mạnh tính toán.

Nvidia công bố, tốc độ và hiệu quả năng lượng trên các chip của họ đã tăng gấp đôi sau mỗi năm, từ năm 2012 đến nay.

Cho dù Intel là nguồn động lực chính của Định luật Moore, nhưng bên cạnh họ còn có hàng trăm công ty khác trên toàn cầu, kéo theo đó là hàng chục nghìn kỹ sư và hàng tỷ USD khác đầu tư vào để tạo nên ngành công nghiệp điện toán như hiện nay. Tương tự như vậy, Nvidia cũng không đơn độc trong việc thúc đẩy Định luật Huang – trên thực tế, loại chip xử lý AI mà họ đang sở hữu chỉ hữu ích trong một số ứng dụng nhất định, và chúng sẽ sớm không còn hấp dẫn nếu Nvidia không mở rộng khả năng xử lý của mình.

Đây có thể chính là nguyên nhân cho việc Nvidia thâu tóm hãng thiết kế chip ARM Holdings vào đầu tháng này với mức giá lên đến 40 tỷ USD.

Khoản tiền đầu tư này liệu có xứng đáng?

Khoản tiền 40 tỷ USD này cũng biến vụ Nvidia thâu tóm ARM Holdings trở thành thương vụ có giá trị lớn nhất từ trước đến nay trong ngành bán dẫn. Tuy nhiên, nếu nhìn vào khả năng tăng cường tốc độ xử lý tác vụ AI mà thương vụ này có thể mang lại, số tiền Nvidia bỏ ra cho thương vụ này là hoàn toàn xứng đáng.

Các ứng dụng AI đang xuất hiện ngày càng phổ biến hơn trên toàn thế giới - từ xe tự hành, các thiết bị cảm biến kết nối internet để mang lại trí thông minh cho các ngôi nhà, nhà xưởng cũng như toàn thành phố, và thậm chí cả các cửa hàng mua sắm với trải nghiệm "lấy hàng và đi" không dùng tiền mặt để thanh toán.

Các hệ thống dùng chip Nvidia với khả năng xử lý hàng chục nghìn tỷ phép tính trên giây đang được ứng dụng tại một số cửa hàng Circle K để xây dựng trải nghiệm "lấy hàng và đi" không cần thanh toán bằng tiền mặt.

Không thể không nhắc đến một loại thiết bị khác đang đưa AI ngày càng gần hơn với người dùng từ giữa những năm 2000 đến nay: smartphone. Từ 2017, Apple đã giới thiệu Neural Engine, chip chuyên dụng cho các tác vụ máy học, mở ra một xu thế mới trong các ứng dụng AI trên thiết bị di động: từ việc xử lý tập trung trên các đám mây, giờ đây đa số tác vụ AI được xử lý ngay trên thiết bị.

Theo Eran Shir, CEO và là nhà đồng sáng lập startup Nexar, Nvidia đang giữ một vị thế gần như độc tôn cho việc xử lý AI trên đám mây. Nhưng điều này đang thay đổi. Khoảng 2 năm trước, 40% việc xử lý dữ liệu của Nexar được thực hiện trên đám mây, nhưng giờ đây, khi các chip ARM có thể xử lý ngày càng nhiều dữ liệu hơn và nhanh hơn ngay trên thiết bị di động, việc xử lý trên đám mây chỉ còn chiếm 15% hoạt động của Nexar.

Các chip AI này không chỉ hiện diện trong hàng triệu smartphone sản xuất ra mỗi năm, mà còn trên hàng loạt thiết bị thông minh khác, từ máy rửa bát cho đến khóa cửa và thậm chí cả bóng đèn, cùng hàng triệu cảm biến khác dành cho những thành phố, nhà xưởng thông minh sắp ra mắt trong thời gian tới.

Kết hợp với các thiết kế chip di động của ARM, sức mạnh xử lý AI đang tăng trưởng theo cấp số nhân của Nvidia có thể hiện diện ở khắp mọi nơi, thay vì chỉ nằm trên đám mây. Do vậy, theo lời giải thích của Shir, đây chính là lý do Nvidia chấp nhận bỏ ra một số tiền lớn đến vậy để thâu tóm ARM Holdings.

Không chỉ Nvidia, nhiều chuyên gia trong ngành cũng nhận thấy đà tăng trưởng tương tự như mô tả về Định luật Huang xuất hiện tại nhiều tổ chức khác. Tổ chức phi lợi nhuận Open AI cho biết, dựa trên các bài kiểm tra kinh điển về nhận diện hình ảnh, họ nhận thấy hiệu năng đang tăng gấp đôi sau mỗi lần 18 tháng.

Nhưng rất có thể cũng giống như định luật Moore hiện nay, định luật Huang cuối cùng cũng sẽ hết động lực tăng trưởng. Nhưng theo Steve Roddy, phó chủ tịch về tiếp thị sản phẩm cho nhóm máy học của ARM, điều này có thể xảy ra trong một thập kỷ nữa. Nhưng trước khi đến thời điểm đó, định luật này có thể là nhân tố thống trị cho sự phát triển của xe tự lái, các cảm biến để làm nên các ngôi nhà, nhà máy và những thành phố thông minh.

Tham khảo Wall Street Journal